Компания Groq представила специализированный языковой процессор значительно опережающий ускорители искусственного интеллекта NVIDIA

В то время как NVIDIA в настоящее время получает гигантскую прибыль, находится на волне подъема популярности искусственного интеллекта с растущим спросом на вычислительные графические процессоры, рынок может стать более разнообразным, поскольку все больше компаний вливаются в создание альтернативных процессоров искусственного интеллекта. В данном направлении наблюдаются весьма серьезные усилия нескольких компаний, включая AMD, d-Matrix, OpenAI и Samsung. Похоже, что немало инженеров, помогавших разрабатывать тензорный процессор Google (TPU), теперь участвуют в независимых проектах в области искусственного интеллекта, которые обещают превзойти решения NVIDIA. Samsung, например, недавно объявила, что ее новую вычислительную лабораторию AGI, открывающуюся в Силиконовой долине, возглавит бывший разработчик Google TPU доктор У Дон Хек. Еще одним ключевым инженером, помогавшим в разработке Google TPU, является Джонатан Росс, который сейчас является генеральным директором новой компании Groq. Используя опыт, накопленный в Google, Росс привносит инновации на рынок ускорителей искусственного интеллекта, выпустив первый в мире блок языковой обработки (LPU).

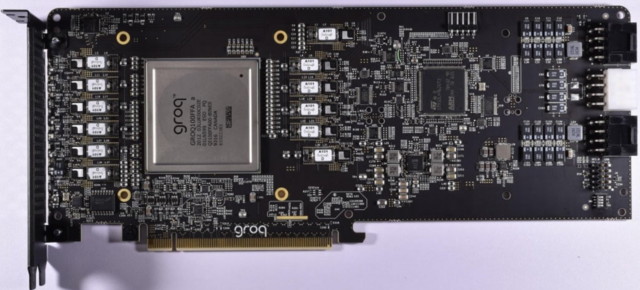

LPU Groq специально разработан для обработки больших языковых моделей (LLM) и имеет явные преимущества перед графическими процессорами общего назначения или NPU. Первоначально Groq разработал Tensor Stream Processor (TSP), который позже был переименован в языковой процессор, чтобы отразить его возросшие способности в задачах генеративного ИИ, основанных на логическом выводе. Поскольку он ориентирован исключительно на LLM, LPU гораздо более оптимизирован, чем GPGPU, и позволяет упростить аппаратное планирование с меньшей задержкой, устойчивой пропускной способностью и повышенной эффективностью.

Следовательно, LPU сокращает время, затрачиваемое на расчет одного слова, и последовательность текста может генерироваться намного быстрее. Еще одним ключевым улучшением является то, что LPU устраняет необходимость в дорогостоящей памяти (HBM), поскольку он использует только 230 МБ SRAM на кристалл с пропускной способностью 80 ТБ/с, что делает его значительно быстрее, чем традиционные решения GPGPU. Архитектура Groq также поддерживает масштабируемость, и несколько LPU можно соединить между собой, чтобы обеспечить повышенную вычислительную мощность для более сложных LLM.

Чтобы продемонстрировать, насколько быстрее механизм вывода LPU по сравнению с графическими процессорами, Groq предоставляет видео-сравнение своего собственного чат-бота, способного переключаться между Llama 2 / Mixtral LLM и Chat-GPT OpenAI. Groq утверждает, что LLM генерирует текст за доли секунды, а остальные 75 процентов времени тратятся на поиск нужной информации.

Рекомендуемые комментарии

Комментариев нет

Присоединяйтесь к обсуждению

Вы можете написать сейчас и зарегистрироваться позже. Если у вас есть аккаунт, авторизуйтесь, чтобы опубликовать от имени своего аккаунта.